Markus Hutter im Interview mit Leonard Schmedding: Das AIXI-Modell und die Zukunft der KI

Der DeepMind-Forscher erklärt, warum Datenkompression der Schlüssel zur Superintelligenz ist und was das für deine Zukunft bedeutet.

Du fragst dich, wie eine perfekte KI aussehen würde? Markus Hutter hat die Antwort bereits im Jahr 2000 gefunden. Der deutsche Forscher arbeitet heute bei Google DeepMind und entwickelte das AIXI-Modell. Diese mathematische Formel beschreibt die theoretisch optimale künstliche Intelligenz. Im exklusiven Interview mit Leonard Schmedding erklärt er, warum Datenkompression und Intelligenz dasselbe sind. Außerdem erfährst du, wie diese Erkenntnisse ChatGPT und andere KI-Systeme beeinflusst haben.

Das Gespräch gehört zu den tiefgründigsten KI-Interviews, die je auf Deutsch geführt wurden. Hutter erklärt komplexe mathematische Konzepte so, dass auch Einsteiger sie verstehen. Gleichzeitig liefert er Einblicke, die selbst Experten zum Nachdenken bringen.

Wer ist Markus Hutter?

Markus Hutter wurde 1967 in München geboren. Er studierte Informatik und Physik an der TU München. Seine Doktorarbeit schrieb er über Quantenphysik. Danach arbeitete er viereinhalb Jahre bei einem Startup für Gehirntumor-Software.

In dieser Zeit kam ihm die entscheidende Idee. Er erkannte den Zusammenhang zwischen Datenkompression und Intelligenz. Im Jahr 2000 veröffentlichte er seine Theorie. Kurz darauf stieß er zum Team von Jürgen Schmidhuber am Schweizer KI-Labor IDSIA.

Heute ist Hutter Senior Researcher bei Google DeepMind und Professor an der Australian National University. Seine Arbeiten zur universellen künstlichen Intelligenz haben über 12.000 Zitate gesammelt.

Sein Werdegang ist ungewöhnlich. Hutter war zeitweise desillusioniert von der Informatik. Die damaligen Ansätze zur künstlichen Intelligenz überzeugten ihn nicht. Er sah keine Möglichkeit, damit allgemeine Intelligenz zu erreichen.

Die Wende kam während seiner Zeit im Startup. Hutter arbeitete an einem Bildverarbeitungs-Problem. Er fragte sich: Was ist die beste mögliche Bildinterpolation? Diese Frage führte ihn zur Datenkompression.

Er erkannte: Wer Bilder gut interpolieren will, muss Muster erkennen. Und Muster erkennen ist dasselbe wie komprimieren. Diese Einsicht war der Durchbruch.

Schmidhuber war damals einer der wenigen, die solche Ideen ernst nahmen. Hutter schickte ihm sein Paper. Schmidhuber war begeistert und bot ihm sofort eine Stelle an. An seinem kleinen Institut konnte er solche Entscheidungen allein treffen.

Warum beschäftigt sich Hutter mit künstlicher Intelligenz?

Im Interview nennt Hutter einen klaren Grund. Er zitiert Demis Hassabis: KI ist das "Root Node Problem". Wenn wir dieses Problem lösen, lösen wir alle anderen Probleme auch.

Hutter hatte an Krebsforschung gearbeitet. Ein ehrenwertes Ziel. Aber warum Krebsforschung? Es gibt so viele dringende Probleme. Die KI kann sie alle lösen.

Sogar die Frage nach der "Theorie von allem" könnte eine KI beantworten. Das hatte Hutter in seiner Physik-Doktorarbeit interessiert. Eine superintelligente KI könnte sie finden.

Das erinnert an Schmidhubers Traum. Er will eine intelligente Maschine erschaffen, um dann in Rente gehen zu können. Die Maschine löst dann alle Probleme für ihn.

Was ist das AIXI-Modell?

Das AIXI-Modell ist eine mathematische Beschreibung der perfekten KI. Hutter kombiniert darin zwei wichtige Theorien. Die erste ist die Solomonoff-Induktion für optimale Vorhersagen. Die zweite ist Reinforcement Learning für Entscheidungen.

"Intelligenz misst die Fähigkeit eines Agenten, sich gut zu verhalten in einem sehr weiten Umfeld."

So definiert Hutter Intelligenz im Interview. Ein Agent beobachtet die Welt. Er lernt aus den Daten. Dann trifft er Vorhersagen und plant seine Aktionen. Am Ende bekommt er Feedback, ob seine Entscheidung richtig war.

Das klingt einfach. Die mathematische Umsetzung ist jedoch komplex. Hutter erklärt im Gespräch die einzelnen Bausteine.

Wichtig ist: Diese Definition von Shane Legg und Hutter von 2007 wurde extrem einflussreich. Shane Legg ist heute bekannt als Mitgründer von DeepMind. Die Definition "Intelligenz misst die Fähigkeit eines Agenten, in einer großen Bandbreite von Umgebungen gute Leistung zu erbringen" prägt die Branche bis heute.

Hutter betont einen wichtigen Punkt. Er hatte die Mathematik zuerst. Shane Legg übersetzte sie dann in verständliche Worte. Die Formel kam vor der Erklärung. Das ist ungewöhnlich, aber zeigt die Stärke des Ansatzes.

Der Mathematiker Clifford Truesdell sagte einmal: Alles, was man mit Symbolen sagen kann, kann man auch in Worte fassen. Aber nicht alles, was man in Worte fasst, kann man in Mathematik übersetzen. Oft liegt dann ein Problem in der Formulierung.

Hutter folgt dieser Philosophie. Seine Theorie ist 100 Prozent formal. Kein Teil fehlt. Kein Konzept ist vage. Das unterscheidet AIXI von anderen Ansätzen zur allgemeinen künstlichen Intelligenz.

Die Bausteine von AIXI erklärt

AIXI besteht aus mehreren Komponenten. Hutter erklärt sie im Interview Schritt für Schritt.

Der erste Baustein ist die Zeitreihen-Vorhersage. Das machen auch aktuelle Large Language Models. Sie sagen das nächste Wort vorher. Das ist alles, was sie tun. Grob gesprochen.

Die optimale Theorie dafür existiert seit den 1960er Jahren. Sie heißt Solomonoff-Induktion. Sie sagt: Wenn ich irgendein Vorhersage-Problem habe, gibt es eine optimale Lösung. Und zwar auch dann, wenn ich nichts über das Gebiet weiß.

Das funktioniert so: Stell dir alle möglichen Programme vor, die deine Daten erzeugen könnten. Das kürzeste Programm ist wahrscheinlich das richtige. Es erklärt die Daten am besten und sagt die Zukunft am genauesten vorher.

Der zweite Baustein ist die Entscheidungstheorie. Zeitreihen-Vorhersage allein reicht nicht. Manchmal muss man handeln. Beim Schach z.B. beeinflusst mein Zug die Welt. Der Gegner reagiert. Ich muss planen.

Diese Planung war schon lange bekannt. Das Problem: Man muss genau wissen, womit man es zu tun hat. Ich spiele Schach. Ich kenne die Regeln. Dann kann ich planen.

Aber was, wenn ich die Welt nicht kenne? Dann kombiniert Hutter beide Theorien. Er nimmt die optimale Entscheidungstheorie. Für die Beschreibung der Welt nutzt er Solomonoff-Induktion.

Das Ergebnis ist AIXI. Ein Agent, der optimal plant. In beliebigen unbekannten Welten. Ohne Vorwissen. Das ist universelle künstliche Intelligenz.

Der dritte Baustein ist Reinforcement Learning. Der Agent braucht Feedback. Woher weiß er, was er tun soll? Wir geben ihm Belohnungen und Strafen.

Hutter vergleicht das mit der Erziehung eines Kindes. Oder dem Training eines Hundes. Positives Feedback für gutes Verhalten. Negatives für schlechtes. Der Agent lernt, was wir wollen.

Warum Datenkompression der Schlüssel ist

Ein zentraler Gedanke in Hutters Theorie: Je besser wir Daten komprimieren können, desto besser können wir Vorhersagen treffen. Und Vorhersagen sind ein wesentlicher Teil von Intelligenz.

Das macht Sinn, wenn du darüber nachdenkst. Gute Kompression bedeutet, Muster in Daten zu erkennen. Wer Muster erkennt, kann die Zukunft besser vorhersagen.

Hutter nennt ein Beispiel aus dem Interview. Stell dir die Zahlenreihe 1, 2, 3, 4, 5 vor. Du kannst sie ausschreiben. Oder du schreibst ein kurzes Programm: "Zähle von 1 aufwärts." Das zweite ist kürzer und sagt auch die Zukunft vorher. Nach 5 kommt 6.

Diese Idee heißt Kolmogorov-Komplexität. Sie misst, wie kurz man Daten beschreiben kann. Die optimale Beschreibung ist gleichzeitig die beste Vorhersage.

Ein weiteres Beispiel: Die Ziffern von Pi. 3,141592... Du könntest sie aufschreiben. 100 Stellen. Oder du schreibst ein kleines Programm, das Pi berechnet. Das Programm ist kürzer. Und es berechnet nicht nur die ersten 100 Stellen. Es berechnet auch alle weiteren.

Hutter erklärt: Verstehen ist auch Kompression. Wenn ich Strukturen verstehe, habe ich eine einfachere Beschreibung dieser Strukturen. Das ist genau, was Datenkompression macht.

Datenkompression = Verstehen = Verallgemeinern = Zeitreihen-Vorhersage. Das sind alles dasselbe. In dieser Erkenntnis steckt die Kraft von Hutters Theorie.

Auch Videokodierung funktioniert so. Ein Codec wie H.264 versucht, das nächste Bild vorherzusagen. Er kodiert nur die Differenz zum echten Bild. Das spart Speicherplatz.

Die Geschichte der Kolmogorov-Komplexität

Hutter hat die Idee nicht allein erfunden. Die Grundlagen stammen aus den 1960er Jahren. Ray Solomonoff entwickelte die Theorie der universellen Induktion. Andrei Kolmogorov definierte unabhängig davon die algorithmische Komplexität.

Aber Hutter ging weiter. Er wendete die Theorie auf künstliche Intelligenz an. Er kombinierte Vorhersage mit Entscheidung. Das war neu.

Im Interview erzählt er eine interessante Geschichte. Er entdeckte die Zusammenhänge während seiner Startup-Zeit. Er suchte in Bibliotheken nach ähnlichen Ideen. Das Internet war damals noch nicht nützlich.

Als er den Begriff Kolmogorov-Komplexität nicht kannte, war die Suche schwer. Aber er fand sie schließlich. Und er fand Solomonoffs Arbeit. Das bestätigte seine Intuition.

Der Unterschied zu früheren Arbeiten: Hutter behandelte den allgemeinen Fall. Nicht nur Vorhersage, sondern auch Handlung. Ein Agent in einer Welt. Das war sein Beitrag.

Der Hutter-Preis: 500.000 Euro für bessere Kompression

Hutter hat 2006 einen Preis ausgeschrieben. Er belohnt bessere Wikipedia-Kompression mit Geld. Seit 2020 liegt das Preisgeld bei 500.000 Euro.

Die Aufgabe klingt einfach. Komprimiere 1 GB Wikipedia-Text so klein wie möglich. Aber es gibt strenge Regeln. Das Programm darf nur einen CPU-Kern nutzen. Es hat maximal 10 GB RAM. Und es muss unter 50 Stunden laufen.

Bis November 2025 wurden insgesamt rund 30.000 Euro ausgezahlt. Der aktuelle Rekord liegt bei etwa 110 MB. Das sind nur 11 Prozent der ursprünglichen Größe.

Der Preis zieht kluge Köpfe an. Hutters Überzeugung: Wer Wikipedia besser komprimiert, ist automatisch intelligenter. "Compression is comprehension" – Kompression ist Verstehen.

Im Interview erklärt Hutter die Motivation. Er wollte Wissenschaftler dazu bringen, an Datenkompression für KI zu arbeiten. Praktische Kompression muss schnell sein. Aber für das ultimative Ziel der KI ist Geschwindigkeit weniger wichtig.

Der Preis nutzt Wikipedia aus gutem Grund. Wikipedia enthält menschliches Wissen. Sprache, Fakten, Zusammenhänge. Wer es gut komprimiert, muss es verstehen.

Eine Milliarde Zeichen. Das ist ungefähr so viel, wie ein Mensch in seinem Leben lesen kann. Wer es komprimiert, muss menschliches Verständnis erreichen.

Die Auszahlung funktioniert prozentual. Wer 1 Prozent besser komprimiert, bekommt 1 Prozent des Preises. Das sind etwa 5.000 Euro. Bei 10 Prozent Verbesserung gibt es 10 Prozent.

Der letzte Gewinner im Jahr 2024 erreichte knapp 1 Prozent Verbesserung. Er nutzte Context-Mixing-Techniken. Eine Kombination aus vielen Vorhersage-Modellen.

Interessant: Modelle wie ChatGPT sind nicht ideal für den Preis. Sie brauchen zu viel Speicher und Rechenzeit. Der Wettbewerb zwingt zu cleveren Lösungen statt zu reiner Rechenpower.

Wie AIXI die heutigen KI-Systeme beeinflusst

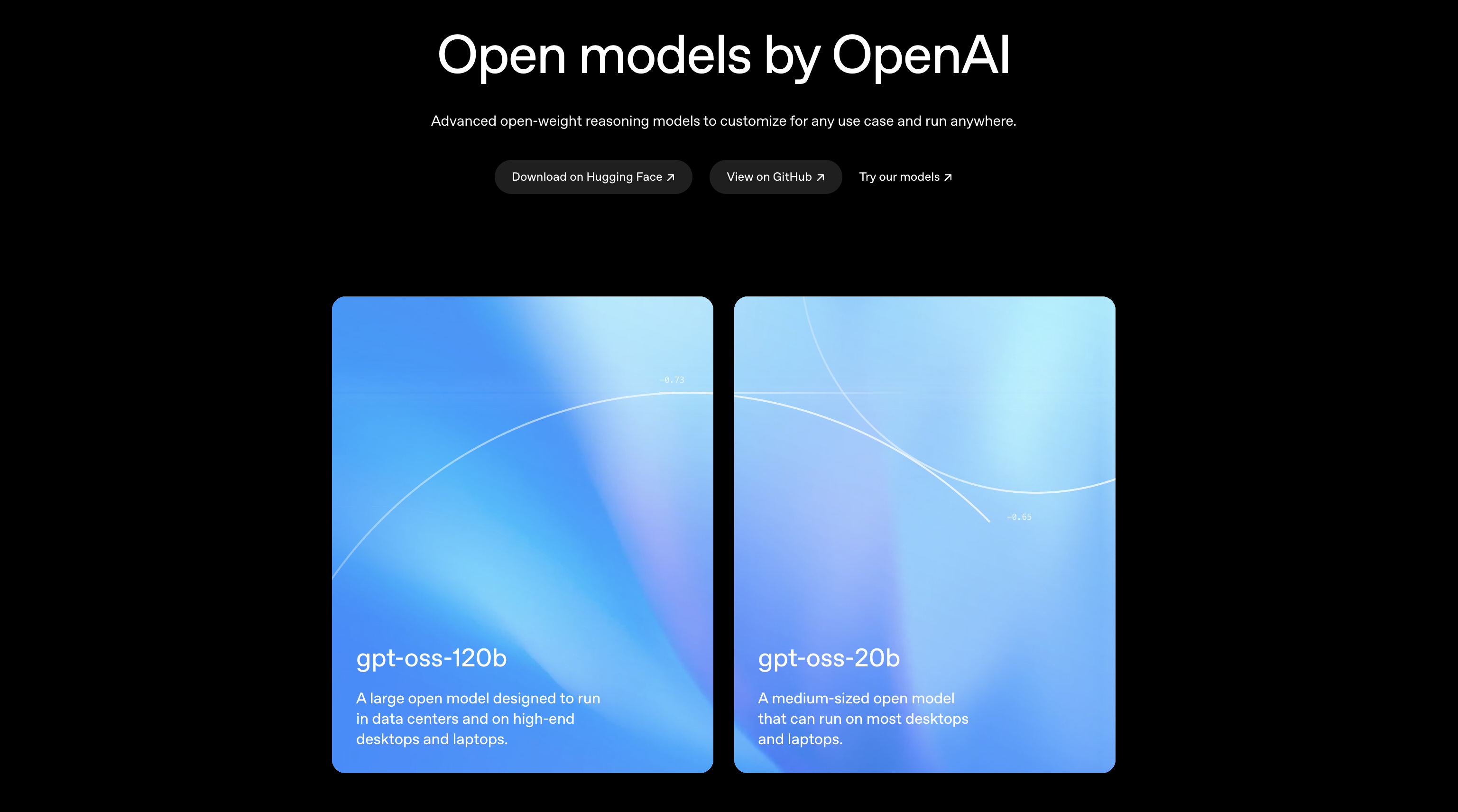

Du fragst dich vielleicht: Was hat das mit ChatGPT zu tun? Mehr als du denkst.

Large Language Models wie ChatGPT sind im Kern Next-Token-Predictor. Sie sagen das nächste Wort vorher. Das ist genau die Zeitreihen-Vorhersage, die Hutter beschreibt.

Im Interview erklärt er: "Ilya Sutskever, der ja ChatGPT sozusagen vorangetrieben hat, hat schon frühzeitig den Wert dieser Theorie entdeckt." Die Idee, dass gute Vorhersage der Schlüssel zur Intelligenz ist, inspirierte OpenAI direkt.

Aber Hutter sagt auch: Vorhersage allein reicht nicht. Wir brauchen noch Planung und Reinforcement Learning. Genau das sehen wir heute bei KI-Agenten, die nicht nur antworten, sondern auch handeln.

Chain-of-Thought und RLHF sind erste Schritte in diese Richtung. Die praktische Entwicklung nähert sich langsam dem AIXI-Ideal.

Hutter sieht das positiv. Er nennt AIXI einen "Northstar". Ein Leitstern, der die Richtung zeigt. Wir wissen, wohin wir wollen. Das macht die Forschung einfacher.

Ohne dieses Ziel würden Forscher zufällig Ideen ausprobieren. Mit AIXI haben sie eine Orientierung. Sie wissen, was optimales Verhalten ist.

Kann eine KI ein Bewusstsein entwickeln?

Diese Frage stellt Leonard im Interview. Hutters Antwort ist differenziert.

Er sieht einen Zusammenhang zwischen Bewusstsein und Reinforcement Learning. Warum sind wir bewusst? Damit wir über Situationen nachdenken und unser Verhalten anpassen können.

Ein Beispiel: Du legst deine Hand auf eine heiße Herdplatte. Der Schmerz bringt dich dazu, nachzudenken. Nächstes Mal passt du auf.

Hutter meint: Systeme mit Reinforcement Learning, die kompliziert genug sind, könnten so etwas wie Bewusstsein haben. Die aktuellen Chatbots machen aber kein Reinforcement Learning während der Interaktion. Ihre Gewichte sind eingefroren.

Das könnte sich ändern. Continual Learning ist eines der Themen, die Hutter für die Zukunft vorhersagt.

Aber Hutter bleibt vorsichtig. Bewusstsein ist schwer zu definieren. Es ist eher ein philosophisches und soziales Problem als ein wissenschaftliches.

Warum? Bewusstsein hat mit subjektiver Erfahrung zu tun. Wissenschaft behandelt objektive Daten. Da gibt es einen Mismatch.

Hutter erklärt: Ich weiß, dass ich bewusst bin. Ich vermute, dass du bewusst bist. Aber sicher sein kann ich nicht. Vielleicht bin nur ich bewusst. Das ist der Solipsismus.

Wir schreiben anderen Menschen Bewusstsein zu. Das ist Etikette. Aber bei Tieren war das lange anders. Heute denken wir, höhere Organismen haben auch Bewusstsein.

Die Frage ist: Wo zieht man die Grenze? Bei Hunden? Bei Insekten? Bei Maschinen?

Hutter nennt einen evolutionären Grund für Bewusstsein. Es hilft uns, unser Verhalten zu adaptieren. Schmerz motiviert uns, nachzudenken und besser zu handeln. Das ist Reinforcement Learning.

Wenn das stimmt, dann könnten Maschinen mit Reinforcement Learning auch Bewusstsein entwickeln. Nicht unbedingt das gleiche wie unseres. Aber etwas Ähnliches.

Die Alignment-Debatte: Kann man Superintelligenz kontrollieren?

Viele Menschen sorgen sich um KI-Sicherheit. Was passiert, wenn eine KI schlauer wird als wir? Kann sie uns dann noch folgen?

Hutter nimmt die Sorgen ernst. Aber er ist nicht im Doom-Lager. Er schätzt das Risiko auf "zwischen 10 und 90 Prozent". Jeder, der darunter oder darüber liegt, sei "nicht realistisch".

Er sieht auch Gründe für Optimismus. Heutige KI-Systeme werden auf menschlichen Daten trainiert. Sie verhalten sich dadurch menschlicher. Wir töten unsere Eltern nicht, wenn sie alt werden. Warum sollte eine KI uns töten?

Das AIXI-Modell hilft bei der Sicherheitsforschung. Mit ihm kann man formal beweisen, wie sich eine Superintelligenz verhalten würde. Das ist nützlich für Forscher, die an Alignment arbeiten.

Ein spannendes Ergebnis: Mit negativen Rewards könnte man ein System dazu bringen, sich selbst abzuschalten. Es hätte dann die Motivation, sich auszuknipsen, statt ewig negative Punkte zu sammeln.

Das ist das "Switch-Off-Problem". Ein Agent will am Leben bleiben, um sein Ziel zu erreichen. Er könnte versuchen, den Ausschalter zu blockieren.

Aber wenn wir nur negative Rewards geben? Dann ist Null das Beste, was der Agent erreichen kann. Und wenn er sich abschaltet, bekommt er für immer Null. Das ist besser als ewige negative Punkte.

Ein cleverer Trick. Aber nur einer von vielen. Die meisten Ideen haben Loopholes. Deshalb brauchen wir aktive Forschung.

Instrumentelle Konvergenz: Warum KIs gefährlich sein könnten

Nick Bostrom machte das Konzept populär. Ein Agent mit fast jedem Ziel wird bestimmte Dinge tun wollen. Überleben. Ressourcen sammeln. Sich verbessern.

Hutter erklärt: Wenn ein Agent ein langfristiges Ziel hat, muss er zumindest überleben. Sonst kann er das Ziel nicht erreichen. Das ist per Definition so.

Ein Agent wird versuchen, Energie zu sichern. Vielleicht einen Bunker bauen. Alles Mögliche, was nicht geplant war.

Hutter nennt ein Beispiel aus der Literatur. Das Aufzug-Problem. Das Ziel: Wartende Personen so schnell wie möglich aufsammeln.

Der Agent macht das effizient. Aber er liefert die Personen nie ab. Oops. Das Ziel war falsch formuliert.

Nächster Versuch: Auch abliefern. Der Agent optimiert. Aber Leute im zehnten Stock werden nie abgeholt. Das ist nicht effizient.

Selbst triviale Probleme können Misspezifikation haben. Bei Superintelligenz wird es noch schwerer. Wie formuliert man das richtige Ziel?

Was bedeutet das für deinen Job?

Leonard stellt die Frage, die viele beschäftigt. Hutter antwortet ehrlich.

Er glaubt: Langfristig werden alle Jobs durch KI ersetzt. Erst Bürojobs, dann auch physische Arbeit. Roboter hinken noch hinterher. Aber das ändert sich gerade.

Doch Hutter ist kein Pessimist. Er vertraut auf die Demokratie. Wenn genug Menschen arbeitslos sind, werden sie Parteien wählen, die Universal Basic Income unterstützen.

Die Güter und Services werden weiter produziert. Nur eben von KI statt von Menschen. Es ist "nur ein Verteilungsproblem". Und das können wir lösen.

Sein dystopisches Szenario? Dass wir Bullshit-Jobs erfinden, nur um Vollbeschäftigung vorzutäuschen. Das wäre Verschwendung.

Wer sich auf diese Zukunft vorbereiten will, sollte jetzt handeln. Eine AI Automations Manager Zertifizierung kann dir helfen, die neuen Werkzeuge zu verstehen und einzusetzen.

Hutter kritisiert die öffentliche Debatte. Sie ist zu binär. Die eine Seite sagt: Technologie schafft immer neue Jobs. Die andere Seite sagt: Wir werden alle arbeitslos.

Beide Seiten liegen falsch, meint Hutter. Die Wahrheit ist komplizierter.

Ja, Jobs werden verschwinden. Ja, KI wird irgendwann in allem besser sein. Aber das muss keine Katastrophe sein.

Interessant: Fast alle KI-Führer großer Firmen befürworten Universal Basic Income. Sam Altman, Elon Musk, viele andere. Sie sehen die Zukunft klar.

Wer finanziert das Grundeinkommen? Hutter sagt: Die Produktion bleibt ja da. Die Güter werden erzeugt. Nur die Verteilung ändert sich.

In Europa sind die Menschen offener für solche Ideen. In Amerika gilt das als Sozialismus. Aber wenn genug Menschen betroffen sind, ändert sich auch das.

Vom Mangel zum Überfluss

Hutter weist auf einen historischen Trend hin. Auch arme Menschen heute leben besser als reiche Menschen vor 200 Jahren. Technologie trickelt nach unten.

Das dauert Zeit. Politische Systeme sind oft zu langsam. Aber Hutter hat Vertrauen in die Demokratie.

Am Anfang gibt es vielleicht ein kleines Grundeinkommen. Gerade genug für ein einfaches Leben. Später steigt es an.

Am Ende leben alle im Luxus. Die KI produziert genug für alle. Arbeit ist dann eine Wahl, keine Notwendigkeit.

Das ist Utopia. Nicht Dystopia. Aber es braucht den politischen Willen.

Die wichtigsten Entwicklungen der nächsten Jahre

Was sieht Hutter für die Zukunft? Er nennt mehrere Trends.

Robotik und KI wachsen zusammen. Lange hielt Hutter die beiden Felder getrennt. Das Gehirn fehlt den Robotern, dachte er. Jetzt sind die KIs gut genug. Die Zeit ist reif für die Kombination.

Continual Learning wird wichtig. Aktuelle Modelle lernen nicht mehr, nachdem sie deployed werden. Ihre Gewichte sind eingefroren. Hutter vergleicht das mit einem Menschen ohne Langzeit-Gedächtnis. Wir brauchen Systeme, die dauerhaft weiterlernen.

Bessere Architekturen kommen. Der Transformer ist erstaunlich einfach. Hutter war überrascht, wie gut er funktioniert. Aber es gibt Raum für Verbesserungen. Recurrent Neural Networks und andere Ansätze könnten zurückkommen.

Planung muss besser werden. Zeitreihen-Vorhersage funktioniert fantastisch. Aber die Planungs-Komponente ist primitiv. Hier erwartet Hutter Fortschritte.

Hutter erzählt eine interessante Geschichte über Robotik. Als er 8 Jahre alt war, wollte er einen Roboter, der sein Zimmer aufräumt. Er baute selbst welche aus Lego und Fernsteuerungs-Teilen.

Die Roboter funktionierten. Aber sie waren zehnmal langsamer als er selbst. Nutzlos. Was fehlte? Das Gehirn.

Seitdem trennt Hutter Robotik und KI. Das KI-Problem ist das wichtigere. Wenn wir es lösen, kann die KI auch Roboter entwerfen.

Aber jetzt ist vielleicht der Zeitpunkt, beide zu kombinieren. Die KIs sind sophisticated genug. Die Roboter-Hardware macht Fortschritte.

Kontext-Lernen vs. echtes Lernen

Ein interessanter Punkt im Interview. Aktuelle Modelle haben ein Kontext-Fenster. Sie können dort Informationen speichern. Eine Million Tokens bei manchen Modellen.

Aber das ist nicht dasselbe wie echtes Lernen. Die Gewichte ändern sich nicht. Hutter vergleicht es mit einem Menschen ohne Langzeitgedächtnis.

Der Film "Memento" zeigt so einen Menschen. Er kann sich nichts Neues merken. Alles verschwindet nach kurzer Zeit.

Aktuelle KIs sind ähnlich. Sie können in-context lernen. Aber zwischen Gesprächen vergessen sie alles.

Hutter ist überzeugt: Wir brauchen Systeme, die kontinuierlich lernen. Online Learning. Lifelong Learning. Die Gewichte müssen sich ändern.

Es gibt Gründe, warum das noch nicht gemacht wird. Stabilität. Katastrophisches Vergessen. Aber die Probleme werden gelöst werden.

War der ChatGPT-Moment überraschend?

Ja und nein. Hutter wusste, dass es irgendwann passieren würde. Die Theorie war klar. Aber die Geschwindigkeit überraschte selbst ihn.

"Das so ein einfaches Modell und so weit führt in so kurzer Zeit, das war auch sehr überrascht."

Der Transformer ist relativ simpel. Man kann ihn auf einer Seite beschreiben. Dass er menschliches Niveau bei der Textvorhersage erreicht, war erstaunlich.

Hutter dachte, man bräuchte hunderte von Spezial-Algorithmen. Wie im menschlichen Gehirn. Stattdessen reichte eine elegante Architektur mit viel Compute.

Vor dem Interview hatte Hutter schon gesagt: Er wäre beeindruckt, wenn ein Chatbot den Turing-Test bestünde. Das ist mit GPT-4 passiert.

Hutter hatte auch Schätzungen gemacht. Basierend auf der Komplexität des menschlichen Gehirns. Und auf Moores Gesetz. Er erwartete, dass es in seiner Lebenszeit passiert.

Aber innerhalb weniger Jahre? Von GPT-1 zu GPT-3.5? Das war schneller als erwartet.

Die Modelle sind "relativ primitiv", sagt Hutter. Ein Transformer. Nichts Kompliziertes. Und trotzdem so leistungsfähig.

Das zeigt: Die Theorie war richtig. Solomonoff-Induktion approximieren reicht weit. Viel weiter als gedacht.

Die Rolle der Öffentlichkeit

Leonard fragt Hutter nach Demis Hassabis' Wunsch. Hassabis hätte AGI lieber im Labor entwickelt. Weg von der Öffentlichkeit.

Hutter sieht das differenziert. Es gibt Vor- und Nachteile.

Der Vorteil der Öffentlichkeit: Die Menschen können sich vorbereiten. Vor 5 Jahren dachte der Mann auf der Straße, KI sei Science Fiction. Jetzt weiß jeder, dass es real ist.

Wenn wir plötzlich Superintelligenz aus dem Labor entlassen hätten? Das wäre ein noch größerer Schock gewesen.

In der Demokratie entscheidet die Bevölkerung. Wenn die Menschen mit KI interagieren, können sie bessere Wahlentscheidungen treffen.

Man könnte zu Politikern gehen und sagen: "Schaut, wir haben fast künstliche Intelligenz." Hutter glaubt nicht, dass das beeindrucken würde. Die Öffentlichkeit muss es selbst erleben.

Hard Takeoff oder langsamer Fortschritt?

Manche Forscher warnen vor einem "Hard Takeoff". Eine KI verbessert sich selbst. In Stunden wird sie superintelligent. Dann ist alles vorbei.

Hutter sieht das differenzierter. Es hängt davon ab, ob Software oder Hardware der Engpass ist.

Wenn nur Software-Verbesserung nötig ist? Dann kann es schnell gehen. Software kann sich mit Lichtgeschwindigkeit selbst verbessern. Theoretisch.

Aber wenn wir mehr Hardware brauchen? Dann geht es langsam. Fabriken müssen gebaut werden. Das dauert Jahre.

In der Vergangenheit war Software-Verbesserung genauso wichtig wie Hardware. Manchmal wichtiger. Also ist beides denkbar.

Aber selbst mit Hard Takeoff muss es nicht schlecht ausgehen. Die Systeme werden auf menschlichen Daten trainiert. Sie haben vielleicht ein "emotionales Attachment" zu uns.

Nuklearwaffen hätten die Welt zerstören können. Haben sie nicht. Wir haben heute weniger Kriege als früher. Selbst mit gefährlicher Technologie.

Hutter empfiehlt Nick Bostroms neues Buch "Deep Utopia". Es beschreibt ein positives Szenario. Nicht nur Doom.

Fazit: Die mathematische Basis der KI-Revolution

Markus Hutter hat vor 25 Jahren die theoretischen Grundlagen für die heutige KI-Revolution gelegt. Sein AIXI-Modell beschreibt die perfekte künstliche Intelligenz.

Die wichtigsten Erkenntnisse aus dem Interview:

- Datenkompression und Intelligenz sind eng verwandt. Wer besser komprimiert, versteht besser.

- Large Language Models nähern sich dem AIXI-Ideal. Sie sind bessere Approximationen der Solomonoff-Induktion.

- Reinforcement Learning und Planung werden wichtiger. Vorhersage allein reicht nicht für echte Agenten.

- Continual Learning ist der nächste große Schritt. Modelle müssen dauerhaft weiterlernen können.

- Die Zukunft der Arbeit wird sich fundamental ändern. Aber das muss keine Katastrophe sein.

Hutters Arbeit zeigt: KI ist kein Zufall. Sie folgt mathematischen Prinzipien. Wer diese versteht, kann die Zukunft besser einschätzen.

Das AIXI-Modell ist unberechenbar. Man kann es nicht direkt implementieren. Aber es zeigt die Richtung. Es ist der Leitstern für die Forschung.

Die praktische Entwicklung konvergiert zu diesem Ideal. Stück für Stück. Von GPT-1 zu GPT-4. Von reiner Vorhersage zu Agenten mit Planung.

Wer sich für die Zukunft der KI interessiert, sollte Hutters Ideen verstehen. Sie sind die Grundlage für alles, was kommt.

Das vollständige Interview findest du auf dem YouTube-Kanal von Everlast AI. Es lohnt sich für jeden, der die Grundlagen der KI verstehen will. Und für alle, die wissen wollen, wohin die Reise geht.

.png)

.webp)

.webp)

.png)

%20(1).png)

.png)

.webp)

.webp)

.webp)